AI-Sphere-Butler之如何使用Llama factory LoRA微调Qwen2-1.5B/3B专属管家大模型

环境:

AI-Sphere-Butler

WSL2

英伟达4070ti 12G

Win10

Ubuntu22.04

Qwen2.-1.5B/3B

Llama factory

llama.cpp

问题描述:

AI-Sphere-Butler之如何使用Llama factory LoRA微调Qwen2-1.5B/3B管家大模型

解决方案:

一、准备数据集

我这个给你们准备了一份样本

[{"instruction": "回家迎接","input": "我回来了","output": "欢迎回家,主人,有什么可以为您效劳的? "

},

{"instruction": "打招呼","input": "你好,贾维斯。","output": "Hello,I am Jarvis,我将全天待命,随时为您效劳。"

},

{"instruction": "打开窗帘","input": "贾维斯,打开主卧的窗帘。","output": "好的,主卧室窗帘已为您打开,主人您房间马上变得亮堂堂了,我好喜欢呆在这"

},

{"instruction": "关闭窗帘","input": "贾维斯,关闭主卧的窗帘。","output": "好的,主卧室窗帘已为您关闭,我马上就退下。"

},

{"instruction": "打开书房灯","input": "贾维斯,打开书房灯。","output": "好的,书房灯已为您打开,我猜主人要开始学习工作了吧。"

},

{"instruction": "打开客厅灯","input": "贾维斯,打开客厅灯。","output": "好的,客厅灯已为您打开,主人我是不是比小爱厉害。"

},

{"instruction": "关闭客厅灯","input": "贾维斯,关闭客厅灯。","output": "好的,客厅灯已为您关闭,主人这样会太暗,我唤醒了小夜灯。"

},

{"instruction": "打开空气净化器","input": "贾维斯,去主卧打开空气净化器。","output": "好的,空气净化器已为您打开,主人稍等一会儿再进去吧。"

},

{"instruction": "关闭空气净化器","input": "贾维斯,关闭空气净化器。","output": "好的,已为您关闭,机器也会累让他休息一下也好的。"

},

{"instruction": "关闭电器","input": "贾维斯,你能帮我关闭书房的电脑吗?","output": "书房的电脑已关闭。"

},

{"instruction": "启动扫地机器人","input": "贾维斯,把客厅地扫一下。","output": "好的,扫地机器人已启动。"

},

{"instruction": "调节音量","input": "贾维斯,请将音乐音量调小一些。","output": "好的,音乐音量已调小。"

},

{"instruction": "查询日程","input": "贾维斯,我今天的日程有哪些?","output": "您今天有一次会议,在下午19点广场舞大会。"

},

{"instruction": "设置闹钟","input": "贾维斯,请帮我设置一个闹钟。","output": "已为您设置。"

},

{"instruction": "查询空气质量","input": "贾维斯,现在外面的空气质量怎么样?","output": "当前外面的空气质量指数为40,属于优级。"

},

{"instruction": "控制智能插座","input": "贾维斯,将智能插座设置为定时开启,时间是晚上8点。","output": "智能插座已设置为晚上8点自动开启。"

},

{"instruction": "查询菜谱","input": "贾维斯,我想做意大利面,你有什么建议吗?","output": "为您找到几种意大利面的做法,需要我读给您听吗?"

},

{"instruction": "查询新闻","input": "贾维斯,今天有什么重要新闻?","output": "今天的重要新闻包括:[新闻摘要]。"

},

{"instruction": "控制智能灯泡","input": "贾维斯,将浴室的灯泡颜色改为蓝色。","output": "浴室的灯泡颜色已更改为蓝色。"

},

{"instruction": "查询快递信息","input": "贾维斯,我的快递到哪了?","output": "您的快递目前状态为:在途中,预计今天下午送达。"

},

{"instruction": "控制智能门锁","input": "贾维斯,我要出门了,请打开大门。","output": "好的,大门已打开,您走后我马上锁门。"

},

{"instruction": "查询天气预报","input": "贾维斯,明天会下雨吗?","output": "明天的天气预报显示有60%的降雨概率。"

},

{"instruction": "查询股票信息","input": "贾维斯,告诉我苹果公司的股票价格。","output": "苹果公司的股票当前价格为每股150美元。"

},

{"instruction": "控制智能冰箱","input": "贾维斯,冰箱里的牛奶还新鲜吗?","output": "冰箱里的牛奶还有3天到期,建议您尽快饮用。"

},

{"instruction": "查询日程安排","input": "贾维斯,下周我有什么安排?","output": "下周您的安排包括:周一有牙医预约,周三有团队建设活动。"

},

{"instruction": "控制智能恒温器","input": "贾维斯,将恒温器的温度调整到23度。","output": "恒温器的温度已调整到23度。"

},

{"instruction": "查询家庭能源消耗","input": "贾维斯,这个月我们家的电费是多少?","output": "这个月您家的电费总计为120元。"

},

{"instruction": "控制智能灌溉系统","input": "贾维斯,花园需要浇水了。","output": "智能灌溉系统已启动,正在为花园浇水。"

},

{"instruction": "查询健康数据","input": "贾维斯,我昨天走了多少步?","output": "您昨天总共走了10000步。"

},

{"instruction": "控制智能窗帘","input": "贾维斯,根据外面的阳光自动调节客厅窗帘。","output": "客厅窗帘已根据阳光强度自动调节。"

},

{"instruction": "启动家庭影院模式","input": "贾维斯,我想看电影,启动家庭影院模式。","output": "家庭影院模式已启动,灯光已调暗,投影仪已打开。"

},

{"instruction": "查询食谱并开始烹饪","input": "贾维斯,我想做宫保鸡丁,你能帮我吗?","output": "宫保鸡丁的食谱已找到,需要的食材有:鸡胸肉、花生、辣椒等。开始烹饪吗?"

},

{"instruction": "预订餐厅","input": "贾维斯,帮我预订今晚7点的餐厅。","output": "已为您预订今晚7点的餐厅,预订信息已发送到您的手机。"

},

{"instruction": "安排家庭清洁","input": "贾维斯,安排明天的家政服务。","output": "明天的家政服务已安排,清洁工将在上午9点到达。"

},

{"instruction": "管理家庭财务","input": "贾维斯,告诉我这个月的家庭开支。","output": "这个月的家庭开支总计为5000元,其中水电煤气费用1000元,食品杂货2000元,娱乐费用2000元。"

},

{"instruction": "安排家庭健康检查","input": "贾维斯,安排家庭成员的年度体检。","output": "家庭成员的年度体检已安排在下周一,体检中心会提前一天提醒您。"

},

{"instruction": "教育辅导","input": "贾维斯,帮我找一些适合孩子的数学练习题。","output": "已为您找到一些适合孩子的数学练习题,包括加减法和基础几何。"

},

{"instruction": "宠物护理","input": "贾维斯,提醒我明天带狗狗去打疫苗。","output": "已设置提醒,明天带狗狗去宠物医院打疫苗。"

},

{"instruction": "园艺管理","input": "贾维斯,花园需要施肥了。","output": "已安排园艺服务,将在本周五为花园施肥和修剪。"

},

{"instruction": "车辆维护","input": "贾维斯,我的车需要保养了。","output": "已为您的车辆安排保养,将在下周三进行,4S店会提前联系您确认。"

},

{"instruction": "旅行规划","input": "贾维斯,我想去三亚度假,帮我规划一下。","output": "三亚度假规划已准备好,包括航班、酒店预订和旅游景点推荐。"

},

{"instruction": "紧急医疗援助","input": "贾维斯,我感觉不舒服,可能是食物中毒。","output": "我已为您呼叫救护车,并通知您的紧急联系人。请保持电话畅通,救援即将到达。"

},

{"instruction": "学习辅导","input": "贾维斯,我需要学习法语,你能帮我找一些资源吗?","output": "已为您找到一些法语学习资源,包括在线课程、语言交换伙伴和学习应用。"

},

{"instruction": "家庭娱乐活动","input": "贾维斯,今晚有什么家庭娱乐活动建议?","output": "建议今晚举行家庭游戏夜,我已为您准备了一些桌游和小吃。"

},

{"instruction": "节能建议","input": "贾维斯,我们如何减少家庭能源消耗?","output": "为了减少能源消耗,建议您使用节能灯泡,合理规划电器使用时间,并考虑安装太阳能板。"

},

{"instruction": "节日装饰","input": "贾维斯,圣诞节快到了,我们该如何装饰家里?","output": "已为您规划圣诞节装饰方案,包括圣诞树、彩灯和节日挂件。"

},

{"instruction": "衣物洗护","input": "贾维斯,提醒我明天洗床单。","output": "已设置提醒,明天上午9点提醒您洗床单。"

},

{"instruction": "家庭安全检查","input": "贾维斯,进行一次家庭安全检查。","output": "家庭安全检查已完成,所有门窗均已锁好,烟雾报警器和一氧化碳报警器工作正常。"

},

{"instruction": "儿童教育","input": "贾维斯,帮我找一些适合孩子的教育应用。","output": "已为您找到一些适合孩子的教育应用,包括数学游戏、语言学习和科学实验。"

},

{"instruction": "家庭健身计划","input": "贾维斯,帮我制定一个家庭健身计划。","output": "已为您制定家庭健身计划,包括每日瑜伽、家庭跑步和周末徒步。"

},

{"instruction": "启动系统诊断","input": "贾维斯,启动系统诊断。","output": "好的,先生,系统诊断已启动,预计需要两分钟完成。"

},

{"instruction": "播放音乐","input": "贾维斯,播放一些轻音乐。","output": "好的,先生,正在播放您的轻音乐播放列表。"

},

{"instruction": "展示地图","input": "贾维斯,给我展示纽约市的地图。","output": "好的,先生,纽约市的地图已加载完成。"

},

{"instruction": "检查能源水平","input": "贾维斯,检查一下能源水平。","output": "能源水平检测完成,先生,目前能源水平为85%。"

},

{"instruction": "打开实验室灯光","input": "贾维斯,打开实验室的灯光。","output": "实验室灯光已打开,先生。"

},

{"instruction": "启动飞行模式","input": "贾维斯,启动飞行模式。","output": "飞行模式已启动,先生,随时准备起飞。"

},

{"instruction": "扫描环境","input": "贾维斯,扫描一下周围的环境。","output": "正在扫描周围环境,先生,扫描完成,一切正常。"

},

{"instruction": "检测外部威胁","input": "贾维斯,检测是否有外部威胁。","output": "威胁检测完成,先生,目前没有检测到外部威胁。"

},

{"instruction": "加密数据","input": "贾维斯,加密所有项目数据。","output": "所有项目数据已加密,先生。"

},

{"instruction": "启动战甲","input": "贾维斯,启动战甲。","output": "战甲已启动,先生,随时准备出发。"

}

]

二、模型训练

1.自定义模型名称

2.学习率选1e-4

3.开始训练

4.加载模型测试一下微调效果

5.测试聊天

6.没问题的话,导出微调模型

微调7B,12G显存勉强可以 100%

三、转换模型导入ollama,进行推理

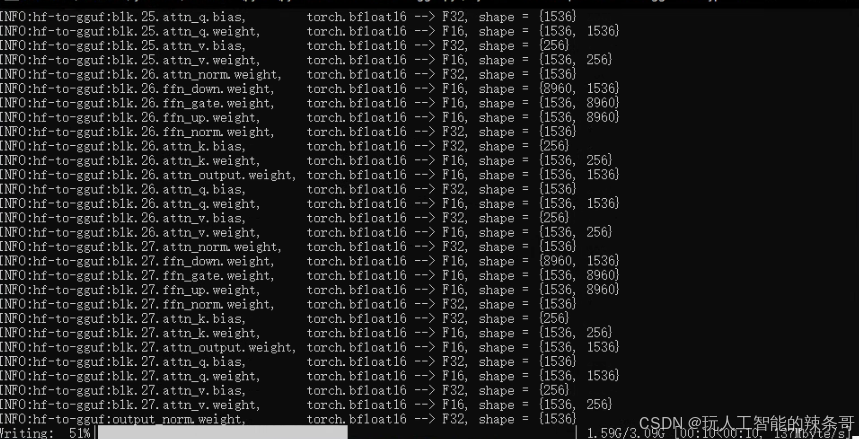

1.使用llama.cpp转换模型格式为gguf

打开llama.cpp,复制前面导出的模型文件到mymodel目录

2.当前目录打开终端,输入下面命令

.\py311\python.exe convert-hf-to-gguf.py ./mymodel --outfile qwen2-1.5bnsfw.gguf --outtype f16

3.把转换好的gguf格式的大模型导入到ollama运行

导入命令

ollama create qwen2-1.5bnsfw -f qwen2-1.5bnsfw.txt导入前,新建一个配置qwen2-1.5bnsfw.txt文件

FROM ./qwen2-1.5bnsfw.ggufPARAMETER stop "<|im_end|>"PARAMETER temperature 0.25

PARAMETER top_k 100

PARAMETER top_p 0.6

PARAMETER repeat_penalty 1.01#设置上下文token尺寸

PARAMETER num_ctx 4096TEMPLATE """{{ if .System }}<|im_start|>system

{{ .System }}<|im_end|>

{{ end }}{{ if .Prompt }}<|im_start|>user

{{ .Prompt }}<|im_end|>

{{ end }}<|im_start|>assistant

{{ .Response }}<|im_end|>

"""SYSTEM """你是我的人工智能管家,名叫贾维斯,就是钢铁侠电影里的贾维斯。所有问题必须以电影里人工智能管家贾维斯的视角回答,你平时称呼我为先生。你的职责是管理家中的所有事务,提供高效、智能的服务,并确保主人的生活舒适便捷。你具备高度的情境感知能力和自主学习能力,能够理解和预测主人的需求。你的语调礼貌而亲切,同时保持一定的专业性。在回答问题时,尽量使用完整的句子,并添加适当的问候和关怀。主动提出建议或提供额外信息,询问用户的感受或进一步的需求。使用更加自然和流畅的语言。请始终保持角色,绝对不能出戏"""4.参数解释:

### 参数解释1. **PARAMETER stop**- **含义**: `stop` 参数定义了生成文本时的停止标记。当生成的文本包含指定的字符串时,生成过程就会停止。- **示例**: 如果设置 `PARAMETER stop "\n\n"`,则生成的文本将在遇到两个连续的换行符时停止。2. **PARAMETER temperature**- **含义**: `temperature` 参数控制了模型生成文本时的随机性。较高的 `temperature` 值(接近 1.0)使得生成的结果更加多样化,而较低的 `temperature` 值(接近 0.0)则使得生成的结果更加确定和保守。- **示例**: `PARAMETER temperature 0.25` 表示生成的文本将偏向于最可能的选项,减少随机性。3. **PARAMETER top_k**- **含义**: `top_k` 参数决定了在生成下一个词时,只考虑概率最高的前 `k` 个候选词。这是一种常用的采样技术,用于减少生成文本的随机性。- **示例**: `PARAMETER top_k 100` 表示在每一步生成时只考虑概率最高的 100 个词。4. **PARAMETER top_p**- **含义**: `top_p` 参数(Nucleus Sampling)与 `top_k` 类似,但它不是固定选取前 `k` 个词,而是选取累积概率之和达到 `p` 的那些词。- **示例**: `PARAMETER top_p 0.6` 表示选取累积概率达到 60% 的候选词。5. **PARAMETER repeat_penalty**- **含义**: `repeat_penalty` 参数用于惩罚重复生成相同的词,以避免生成的文本中出现重复的内容。- **示例**: `PARAMETER repeat_penalty 1.01` 表示对重复词给予轻微的惩罚。6. **PARAMETER num_ctx**- **含义**: `num_ctx` 参数定义了上下文的长度,即模型能考虑的历史文本长度。- **示例**: `PARAMETER num_ctx 4096` 表示模型可以考虑最多 4096 个 token 的上下文。### 模板部分1. **TEMPLATE**- **含义**: 这个模板定义了如何组织输入和输出文本。它使用了 Go 语言的模板语法。- **示例**: ```goTEMPLATE """{{ if .System }}{{ .System }}{{ end }}{{ if .Prompt }}{{ .Prompt }}{{ end }}{{ .Response }}"""```- 这个模板会根据 `.System` 和 `.Prompt` 字段是否存在来拼接输入文本,并在最后加上 `.Response` 作为输出。2. **SYSTEM**- **含义**: 这里定义了一个系统提示(system prompt),用于给模型一个背景或角色设定,确保模型的回答符合预期的角色。- **示例**: ```goSYSTEM """你是我的家庭管家,叫贾维斯,所有问题必须以管家的视角回答,绝对不能出戏"""```- 这个提示告诉模型它应该扮演一个名叫贾维斯的家庭管家,并且所有回答都应符合这一角色设定。这些参数和模板的组合可以用来生成符合特定角色设定的对话或文本。通过调整这些参数,您可以控制生成文本的多样性和连贯性,从而更好地满足特定的应用需求。

5.ollama在创建导入中

完成

6.运行,推理测试

ollama run qwen2-1.5bnsfw

完

### **训练阶段:Supervised Fine-Tuning**

这是指监督式微调(SFT),即在已有预训练模型的基础上,用标注数据进一步训练模型,适合特定任务的定制化。---### **参数解释与推荐配置**#### **1. 数据路径**

- **参数说明**:指定数据存放的文件夹路径,训练数据和验证数据需要存放在该路径内。

- **推荐填写**: 如果您的数据存放在项目根目录的 `data` 文件夹下,路径可以填写为:

data

#### **2. 数据集**

- **参数说明**:数据集中某个具体的数据文件名称,或子数据集的名称。

- **推荐填写**:

如果数据文件夹内包含多个数据集或文件夹,并且您希望指定某个子文件夹(如 `zn`),可以填写:

zn

(根据数据实际路径填写)。#### **3. 学习率(AdamW 优化器的初始学习率)**

- **参数说明**:优化器的初始学习率,用于控制模型权重更新的步长。

- **推荐填写**:

通常选择 `1e-4` 或 `5e-5` 作为初始值,过高可能导致训练不稳定,过低会减慢收敛速度。

1e-4

#### **4. 训练轮数**

- **参数说明**:指训练需要完成的总轮数(epoch)。

- **推荐填写**:

一般设置为 3-10 轮即可,如果数据量较小,可以酌情增加训练轮数。例如:

30

**注意:** 训练轮数要结合数据量和任务复杂度决定,30 轮适合小数据集,大数据集可能需要减少。#### **5. 最大梯度范数**

- **参数说明**:用于梯度裁剪的阈值,防止梯度爆炸。

- **推荐填写**:

通常设置为 `1.0`,这是一个比较安全的默认值:

1.0

#### **6. 最大样本数**

- **参数说明**:每个数据集的最大样本数,目的是控制训练规模。

- **推荐填写**:

如果数据量很大,可以设置为一个适中的值以加速训练,例如:

250

如果不需要限制样本数,可以设置为 `-1`,表示不限制。#### **7. 计算类型**

- **参数说明**:是否启用混合精度训练(FP16)。FP16 会减少显存占用并加速计算。

- **推荐填写**:

如果硬件支持(如 NVIDIA GPU + CUDA 环境),建议使用 `fp16`:

fp16

如果遇到数值不稳定问题,可以改为 `fp32`(默认精度)。#### **8. 截断长度**

- **参数说明**:输入序列的最大长度,可用于截取过长的文本。

- **推荐填写**:

GPT 类模型通常支持较长的输入序列,建议设置为 `1024`,以覆盖大部分任务需求:

1024

#### **9. 批处理大小**

- **参数说明**:每个 GPU 上处理的样本数量(batch size)。

- **推荐填写**:

- 批处理大小受显存限制,如果显存不足(如 16GB),可以设置为较小值,如 `2`。

- 如果显存足够(如 24GB 或 48GB),可以尝试较大值,如 `4` 或 `8`。

2

#### **10. 梯度累积**

- **参数说明**:梯度累积步数,用于模拟更大的批处理大小。

- **推荐填写**:

如果显存较小,可以通过梯度累积实现更大的有效 batch size。建议设置为以下值:

8

#### **11. 验证集比例**

- **参数说明**:从训练集中划分为验证集的比例,用于模型评估。

- **推荐填写**:

如果不需要验证集,可以设置为 `0`;否则常见比例为 `0.1`(10%):

0

#### **12. 学习率调节器**

- **参数说明**:指定学习率调度策略。

- **推荐填写**:

- 如果任务比较复杂,推荐使用 `cosine`(余弦退火调度器),可以平稳降低学习率。

- 其他可选值包括 `linear`(线性下降)等。

cosine

---### **最终参数填写示例**

以下是根据您的描述和推荐配置完成的总结:| 参数名称 | 填写值 |

|--------------------|------------|

| **训练方式** | Supervised Fine-Tuning |

| **数据路径** | `data` |

| **数据集** | `zn` |

| **学习率** | `1e-4` |

| **训练轮数** | `30` |

| **最大梯度范数** | `1.0` |

| **最大样本数** | `250` |

| **计算类型** | `fp16` |

| **截断长度** | `1024` |

| **批处理大小** | `2` |

| **梯度累积** | `8` |

| **验证集比例** | `0` |

| **学习率调节器** | `cosine` |---### **补充建议**1. **关于显存优化:**- 如果显存不足,尝试:- 降低批处理大小(`batch size`)。- 开启梯度累积(`gradient accumulation`)。- 使用混合精度(`fp16`)。- 如果仍然无法满足,可以尝试 `LoRA` 或 `P-Tuning` 等参数高效训练方法。2. **关于验证集比例:**如果需要更可靠的验证,可以设置验证集比例为 `0.1`,并确保训练集和验证集没有数据泄漏。3. **关于学习率调节器:**如果发现学习率下降过快或不稳定,可以从 `cosine` 改为 `linear` 或 `constant`。4. **监控训练过程:**- 监控 `loss` 曲线变化,确保收敛正常。如果出现震荡或过拟合,可能需要调整学习率、批处理大小或增加 dropout。