NIPS2021 | 视觉 Transformer 的有趣特性

Intriguing Properties of Vision Transformers

- 摘要-Abstract

- 引言-Introduction

- 相关工作-Related Work

- 视觉Transformer的有趣特性-Intriguing Properties of Vision Transformers

- 视觉Transformer对遮挡具有鲁棒性吗?-Are Vision Transformers Robust to Occlusions?

- 形状与纹理:Transformer能否对两种特征同时建模?-Shape vs. Texture: Can Transformer Model Both Characteristics?

- 位置编码是否保留全局图像上下文?-Does Positional Encoding Preserve the Global Image Context?

- 视觉Transformer对对抗性和自然扰动的鲁棒性-Robustness of Vision Transformers to Adversarial and Natural Perturbations

- 视觉Transformer的有效现成标记-Effective Off-the-shelf Tokens for Vision Transformer

- 讨论和结论-Discussion and Conclusion

论文链接

GitHub链接

本文 “Intriguing Properties of Vision Transformers” 系统研究了视觉 Transformer(ViT)的特性,并与CNN对比。发现 ViT 对严重遮挡、扰动和域偏移具有高度鲁棒性;其对形状的识别能力强,纹理偏差小,经训练可实现无像素级监督的语义分割;ViT 的现成特征可组合成特征集合,在传统和少样本学习范式中表现出色。研究还探讨了位置编码等因素对 ViT 性能的影响,为后续研究提供了方向。

摘要-Abstract

Vision transformers (ViT) have demonstrated impressive performance across numerous machine vision tasks. These models are based on multi-head self-attention mechanisms that can flexibly attend to a sequence of image patches to encode contextual cues. An important question is how such flexibility (in attending image-wide context conditioned on a given patch) can facilitate handling nuisances in natural images e.g., severe occlusions, domain shifts, spatial permutations, adversarial and natural perturbations. We systematically study this question via an extensive set of experiments encompassing three ViT families and provide comparisons with a high-performing convolutional neural network (CNN). We show and analyze the following intriguing properties of ViT: (a) Transformers are highly robust to severe occlusions, perturbations and domain shifts, e.g., retain as high as 60% top-1 accuracy on ImageNet even after randomly occluding 80% of the image content. (b) The robustness towards occlusions is not due to texture bias, instead we show that ViTs are significantly less biased towards local textures, compared to CNNs. When properly trained to encode shape-based features, ViTs demonstrate shape recognition capability comparable to that of human visual system, previously unmatched in the literature. © Using ViTs to encode shape representation leads to an interesting consequence of accurate semantic segmentation without pixel-level supervision. (d) Off-the-shelf features from a single ViT model can be combined to create a feature ensemble, leading to high accuracy rates across a range of classification datasets in both traditional and few-shot learning paradigms. We show effective features of ViTs are due to flexible and dynamic receptive fields possible via self-attention mechanisms.

视觉Transformer(ViT)在众多机器视觉任务中展现出了令人瞩目的性能。这些模型基于多头自注意力机制,能够灵活地关注一系列图像patch,对上下文线索进行编码。一个重要的问题是,这种灵活性(即基于给定patch关注全图上下文)如何有助于处理自然图像中的干扰因素,例如严重遮挡、域偏移、空间排列变化、对抗性扰动和自然扰动。我们通过涵盖三个ViT系列的大量实验,系统地研究了这个问题,并与高性能卷积神经网络(CNN)进行了比较。我们展示并分析了ViT的以下有趣特性:(a)Transformer对严重遮挡、扰动和域偏移具有高度鲁棒性,例如,即使在随机遮挡ImageNet中80%的图像内容后,仍能保持高达60%的top-1准确率。(b)对遮挡的鲁棒性并非源于纹理偏差,相反,我们发现与CNN相比,ViT对局部纹理的偏差明显更小。经过适当训练以编码基于形状的特征后,ViT展现出的形状识别能力可与人类视觉系统相媲美,这在以往的文献中是前所未有的。(c)使用ViT对形状表示进行编码会产生一个有趣的结果,即无需像素级监督即可实现精确的语义分割。(d)单个ViT模型的现成特征可以组合形成特征集合,在传统和少样本学习范式下的一系列分类数据集中都能实现高准确率。我们证明了ViT的有效特征得益于通过自注意力机制实现的灵活动态感受野。

引言-Introduction

这部分内容主要阐述了研究视觉Transformer(ViT)学习表示特性的重要性,对比了其与卷积神经网络(CNN)在处理多种干扰因素和泛化能力上的差异,介绍了实验基于的模型和数据集,并说明了研究的主要发现和创新设计,具体如下:

- 研究背景与动机:ViT在机器视觉领域备受关注,研究其学习表示特性至关重要,尤其是在安全关键应用场景下,需要模型具有强大的鲁棒性和泛化能力。

- 研究内容:对比ViT与CNN在处理遮挡、分布转移、对抗和自然扰动等干扰因素,以及在不同数据分布上的泛化能力。基于ViT、DeiT和T2T三个Transformer家族,在十五个视觉数据集上展开深入分析。

- 研究发现

- 遮挡鲁棒性:与最先进的CNN相比,ViT在面对前景物体、非显著背景区域和随机补丁位置的严重遮挡时表现出更强的鲁棒性。例如,在ImageNet验证集上,DeiT在高达80%的随机遮挡下,仍能保持约60%的top-1准确率,而此时CNN准确率为零。

- 形状识别优势:在形状识别任务中,ViT表现优于CNN,且与人类视觉系统相当,对纹理的依赖程度低于CNN,这使其在处理纹理较少的数据(如绘画)时,能更好地识别物体形状。

- 综合鲁棒性:ViT在应对空间patch级排列、对抗扰动和常见自然损坏(如噪声、模糊、对比度变化和像素化伪影)等干扰因素时,表现出比CNN更好的鲁棒性。不过,专注于形状训练的ViT和CNN一样,在面对对抗攻击和常见损坏时较为脆弱。

- 特征泛化能力:ImageNet预训练模型的现成ViT特征在新领域(如少样本学习、细粒度识别、场景分类和长尾分类)中具有出色的泛化能力。

- 创新设计:提出对DeiT的架构修改,通过专用token编码形状信息,实现同一架构内对不同线索的建模,进而在无像素级监督下实现自动分割;还介绍了现成特征转移方法,利用单一架构的表示集合,结合预训练ViT获得了最先进的泛化性能。

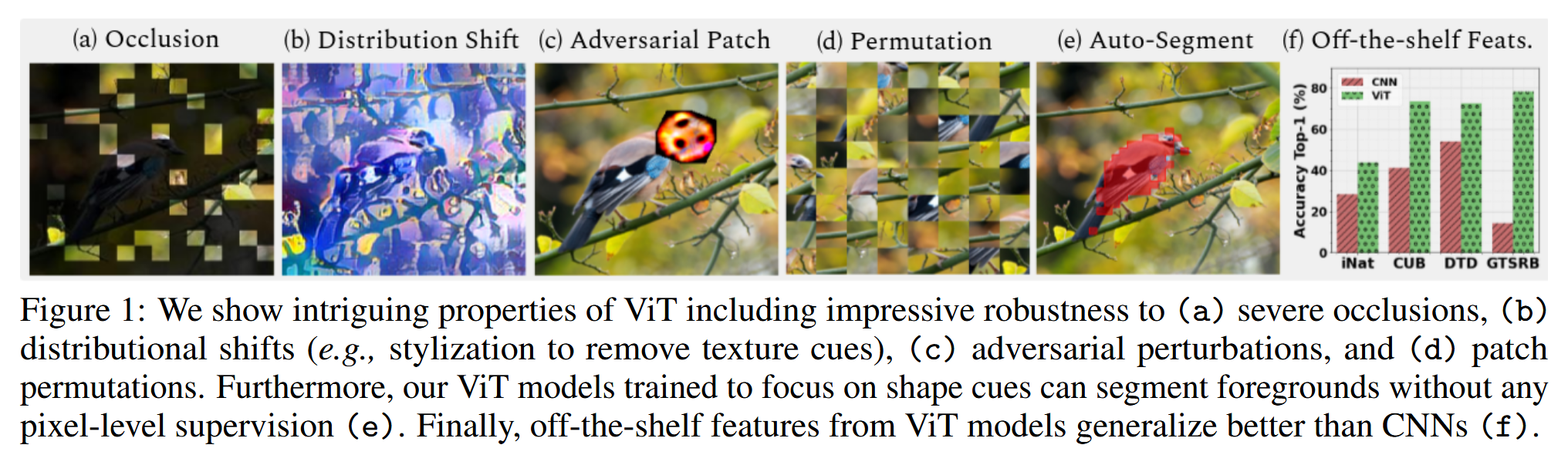

图1:我们展示了视觉Transformer(ViT)的一些有趣特性,包括其对以下情况表现出的令人印象深刻的鲁棒性:(a)严重的遮挡;(b)分布偏移(例如,通过风格化处理去除纹理线索);(c)对抗性扰动;以及(d)补丁排列。此外,我们经过训练、专注于形状线索的视觉Transformer(ViT)模型能够在没有任何像素级监督的情况下分割前景(e)。最后,视觉Transformer(ViT)模型的现成特征比卷积神经网络(CNNs)的泛化能力更好(f)。

相关工作-Related Work

这部分内容主要回顾了与视觉Transformer(ViT)相关的研究工作,包括CNN和ViT在鲁棒性、形状与纹理学习、特征可视化与泛化等方面的研究,具体如下:

- CNN与ViT的鲁棒性研究对比:CNN在独立同分布(i.i.d)设置下表现出色,但对分布偏移(对抗噪声、常见图像损坏和域偏移)敏感。已有研究分析了ViT对对抗噪声、空间扰动等的鲁棒性,本文则重点关注ViT对patch掩蔽、局部对抗patch和常见自然损坏的鲁棒性,与其他类似研究实验设置有所不同 。

- 形状与纹理学习研究:有研究表明CNN主要利用纹理进行决策,对全局形状重视不足,而本文分析发现大的ViT模型纹理偏差较小,更注重形状信息,在直接在风格化ImageNet上训练时,形状偏差接近人类水平,且本文展示了形状聚焦学习可使图像级监督的ViT模型具备自动分割能力,这与之前关于自监督ViT可自动分割前景物体的研究不同。

- 特征可视化与泛化研究:有方法用于可视化CNN特征并研究现成特征的性能,本文类似地研究了ViT现成特征的泛化能力,并与CNN进行比较。同时,Transformer模型的感受野覆盖整个输入空间,相比CNN更能建模全局上下文和保留结构信息,本文致力于展示ViT灵活感受野和基于内容的上下文建模对学习特征的鲁棒性和泛化性的有效性。

视觉Transformer的有趣特性-Intriguing Properties of Vision Transformers

视觉Transformer对遮挡具有鲁棒性吗?-Are Vision Transformers Robust to Occlusions?

该部分主要研究视觉Transformer(ViT)在遮挡场景下的鲁棒性,通过设计不同的遮挡方式进行实验,并从模型准确率、注意力可视化和特征相关性等方面进行分析,得出ViT对遮挡具有高度鲁棒性的结论,具体内容如下:

- 遮挡建模方法:采用PatchDrop策略定义遮挡,即将输入图像表示为patch序列,选择部分patch并将其像素值设为零来创建遮挡图像。具体有三种变体:

- 随机PatchDrop:随机选择M个patch进行丢弃,如将224×224×3的图像分成196个16×16×3的patch,丢弃100个patch相当于损失51%的图像内容。

- 显著(前景)PatchDrop:利用自监督ViT模型DINO定位显著像素,选择包含前Q%前景信息的补丁进行丢弃,Q%不总是对应像素百分比。

- 非显著(背景)PatchDrop:与显著PatchDrop方法类似,选择包含最低Q%前景信息的补丁进行丢弃。

图2:一张示例图像及其不同的遮挡版本(随机遮挡、显著区域遮挡和非显著区域遮挡)。被遮挡的图像能够被Deit-S模型[3]正确分类,但却被ResNet50模型[28]错误分类。遮挡(黑色)区域的像素值被设为零。

- 模型在遮挡下的鲁棒性能:使用在ImageNet上预训练的模型进行视觉识别任务,在验证集上研究遮挡的影响。定义信息损失(IL)为丢弃patch数与总patch数的比率,通过改变IL获得不同遮挡水平。结果显示,ViT模型在对抗遮挡方面比CNN表现更出色。例如,在随机PatchDrop中,当50%的图像信息被随机丢弃时,ResNet50(2300万参数)准确率仅0.1%,而DeiT-S(2200万参数)可达70%;当90%的图像信息被随机遮挡时,Deit-B仍有37%的准确率,且这种鲁棒性在不同ViT架构中一致。同时,ViT对前景和背景内容的移除也表现出显著的鲁棒性。

图3:在三种补丁丢弃设置下(见3.1节)研究了图像中对物体遮挡的鲁棒性。(左图)我们研究了卷积神经网络(CNN)模型对遮挡的鲁棒性,并将ResNet50确定为一个强大的基线模型。(左中图)我们将DeiT模型系列与ResNet50进行比较,结果表明DeiT模型系列对物体遮挡具有更强的鲁棒性。(右中图)与视觉Transformer(ViT)模型系列进行比较。(右图)与T2T模型系列进行比较。 - ViT表示对信息损失的鲁棒性:为理解模型在遮挡下的行为,可视化不同层每个头的注意力发现,初始层关注所有区域,深层则更聚焦于图像非遮挡区域的剩余信息。通过计算原始图像和遮挡图像特征/令牌之间的相关系数,发现ViT的类令牌比ResNet50的特征更鲁棒,信息损失更少,且该趋势在不同类别的图像中都成立。

图4:与在ImageNet上预训练的DeiT-B模型的多个层中每个注意力头相关的注意力图(在整个ImageNet验证集上取平均值)。所有图像都用相同的掩码(右下角)进行了遮挡(随机补丁丢弃)。请注意,模型的较后层如何清晰地关注图像的未遮挡区域以做出决策,这证明了该模型具有高度动态的感受野。

表1:在随机补丁丢弃情况下,原始图像与被遮挡图像的特征/最终类别令牌之间的相关系数。数据为在ImageNet验证集上的平均值。

图5:在50%随机遮挡情况下,原始图像与被遮挡图像的特征/最终令牌之间的相关性。结果是对每个超类中的各类别取平均值得到的。

形状与纹理:Transformer能否对两种特征同时建模?-Shape vs. Texture: Can Transformer Model Both Characteristics?

这部分主要探究Transformer能否同时对形状和纹理特征进行建模,通过实验表明ViT在形状识别上比CNN表现更优,且引入形状token后能在同一架构中平衡两种特征的建模,还能实现无像素级监督的自动语义分割,具体内容如下:

- 训练无局部纹理模型:借鉴前人研究,通过创建名为SIN的风格化ImageNet数据集,去除训练数据中的局部纹理线索,然后在该数据集上训练DeiT模型。研究发现,在ImageNet上训练的ViT比类似容量的CNN具有更高的形状偏差,而在SIN上训练的ViT在形状识别任务上表现更优,DeiT-S在SIN上训练时甚至能达到人类水平的性能。

图6:形状偏差分析:形状偏差被定义为基于物体形状做出正确决策的比例。(左图)该图展示了卷积神经网络(CNN)、视觉Transformer(ViT)和人类在不同物体类别上在形状与纹理方面的权衡情况。(右图)为类别平均形状偏差比较。总体而言,视觉Transformer(ViT)的表现优于卷积神经网络(CNN)。当在风格化的ImageNet(SIN)上进行训练时,形状偏差会显著增加。 - 形状蒸馏:采用知识蒸馏方法,引入新的token令牌,从在SIN数据集上训练的CNN(ResNet50-SIN)中蒸馏形状知识到ViT模型。实验表明,ViT的特征具有动态性,可通过辅助token聚焦于所需特征。引入形状token后,ViT模型在分类性能和形状偏差度量上实现了更平衡的表现,且类token和形状token之间的余弦相似度较低,证实了它们能建模独特特征,这是CNN难以实现的。

表3:在风格化ImageNet(SIN)上训练的模型的性能比较。视觉Transformer(ViT)生成的动态特征可以由辅助令牌进行控制。“cls”代表类别令牌。在蒸馏过程中,与[3]相比,使用相同的特征时,类别令牌(cls)和形状令牌收敛到截然不同的结果。

图7:形状蒸馏。 - 形状偏置的ViT实现自动目标分割:训练无局部纹理或经过形状蒸馏的ViT能够专注于场景中的前景物体,忽略背景,从而实现图像的自动语义分割,尽管模型从未见过像素级的物体标签。通过计算Jaccard指数评估,发现这种方法下的ViT模型在PASCAL - VOC12验证集上的表现接近自监督方法DINO。

表4:我们在PASCAL-VOC12验证集上,计算了真实标注与由视觉Transformer(ViT)模型的注意力图生成的掩码之间的杰卡德相似度(与[23]中的方法类似,阈值设为0.9)。在训练这些模型时仅使用了ImageNet的类别级别标签。我们的结果表明,有监督的ViT模型可用于自动分割,并且其表现与自监督方法DINO [23]更为接近。

图8:视觉Transformer(ViT)生成的分割图。形状蒸馏模型的表现优于标准监督模型。

位置编码是否保留全局图像上下文?-Does Positional Encoding Preserve the Global Image Context?

这部分内容主要研究位置编码对ViT保持全局图像上下文的作用,通过对图像patch进行打乱操作改变其空间结构,分析模型在结构信息变化下的表现,发现位置编码对ViT性能并非至关重要,具体如下:

- 对空间结构的敏感性:定义一种对输入图像patch的打乱操作,去除图像中的结构信息(空间关系)。以DeiT模型为例,研究其在输入图像空间结构被干扰时的准确率变化。结果显示,当图像空间结构受到干扰时,DeiT模型比CNN更能保持准确率,这表明位置编码并非做出正确分类决策的绝对关键因素,模型并非依靠位置编码中保存的patch序列信息来“恢复”全局图像上下文。

图9:对图像应用洗牌操作以消除其结构信息的示意图。(放大查看效果最佳)

图10:使用196个图像补丁训练的模型。在ImageNet验证集上,当补丁被打乱时的top-1准确率(%)。请注意,当打乱网格大小等于训练时使用的原始补丁数量时,性能达到峰值,因为这仅仅相当于改变了输入补丁的位置(而不会干扰补丁内容)。 - 位置编码的实际作用:实验表明,没有位置编码时,ViT仍能表现出较好的排列不变性,甚至比使用位置编码的ViT表现更好。在改变ViT训练时的patch大小时,发现随着patch尺寸减小,模型在未打乱自然图像上的准确率和排列不变性都会下降。总体而言,ViT的排列不变性性能主要归因于其动态感受野,它能根据输入patch调整注意力,使元素适度打乱不会显著降低性能。

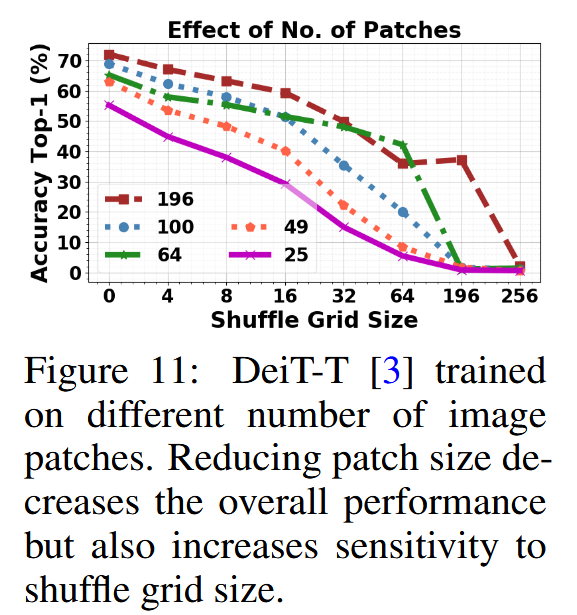

图11:使用不同数量图像补丁训练的DeiT-T模型[3]。减小补丁大小会降低整体性能,但也会增加对打乱网格大小的敏感性。

视觉Transformer对对抗性和自然扰动的鲁棒性-Robustness of Vision Transformers to Adversarial and Natural Perturbations

这部分主要研究视觉Transformer(ViT)对对抗性和自然扰动的鲁棒性,探讨了形状偏置与鲁棒性的关系,以及不同训练条件和攻击方式下ViT的表现,具体内容如下:

- 研究问题:在分析ViT编码形状信息能力后,探究更高的形状偏置是否有助于实现更好的鲁棒性。

- 实验方法:通过计算平均腐败误差(mCE),在多种合成的常见图像腐败情况(如雨水、雾气、雪花和噪声等)下,对具有相似参数数量的ViT(如DeiT-S)和ResNet50进行测试;同时研究它们在无目标的通用对抗补丁攻击以及特定样本攻击(包括单步的快速梯度符号法(FGSM)和多步的投影梯度下降攻击(PGD))下的鲁棒性。

- 实验结果

- 常见图像腐败:ViT(如DeiT-S)比经过增强训练(Augmix)的ResNet50更能抵抗图像腐败;同时,在ImageNet或SIN上未经增强训练的CNNs和ViTs对腐败更敏感,这表明增强训练有助于提高对常见腐败的鲁棒性。

表4:常见图像损坏情况下的平均损坏误差(mCE)[13](数值越低越好)。虽然视觉Transformer(ViT)相比卷积神经网络(CNN)具有更好的鲁棒性,但为实现更高形状偏差而进行的训练会使CNN和ViT在面对自然分布变化时都更加脆弱。与在ImageNet或风格化ImageNet(SIN)上未经增强训练的模型相比,所有经过增强训练(无论是ViT还是CNN)的模型的mCE都更低。 - 对抗攻击:在对抗攻击方面,在SIN上训练的ViTs和CNNs比在ImageNet上训练的模型更容易受到攻击,这体现了形状偏置与鲁棒性之间的权衡关系。不过,即使参数较少,ViT在对抗攻击下的鲁棒性也高于CNN 。

图12:对抗对抗补丁攻击的鲁棒性。即使参数较少,视觉Transformer(ViT)也比卷积神经网络(CNN)表现出更高的鲁棒性。在ImageNet上训练的模型比在风格化ImageNet(SIN)上训练的模型更具鲁棒性。结果是在ImageNet验证集上进行五次补丁攻击的平均值。

图13:针对特定样本攻击(包括单步的快速梯度符号法(FGSM)[34]和多步的投影梯度下降法(PGD)[35])的鲁棒性。即使参数较少,视觉Transformer(ViT)也比卷积神经网络(CNN)表现出更高的鲁棒性。PGD仅运行5次迭代。攻击在无穷范数((l_{\infty}) norm)下进行评估,ϵ表示输入图像中每个像素的扰动预算。结果是在ImageNet验证集上报告的。

- 常见图像腐败:ViT(如DeiT-S)比经过增强训练(Augmix)的ResNet50更能抵抗图像腐败;同时,在ImageNet或SIN上未经增强训练的CNNs和ViTs对腐败更敏感,这表明增强训练有助于提高对常见腐败的鲁棒性。

视觉Transformer的有效现成标记-Effective Off-the-shelf Tokens for Vision Transformer

这部分主要研究了视觉Transformer(ViT)现成特征的有效性,发现ViT模型各块生成的类令牌可单独处理,通过实验确定了有效令牌组合方式,且其在多种任务中的特征转移性优于CNN,具体内容如下:

- 特征提取与转移方法:ViT模型独特之处在于每个块都能生成可被分类头单独处理的类令牌。通过分析DeiT模型块级分类准确率,发现深层块生成的类令牌更具判别力。基于此,在CUB、Flowers和iNaturalist等数据集上进行迁移学习实验,将不同块的类令牌(可选地结合平均补丁令牌)连接起来,训练线性分类器来转移特征。结果表明,连接最后四个块的类令牌(DeiT-S(ensemble)策略)在迁移学习中表现最佳;连接所有块的类令牌和平均补丁令牌虽能达到类似性能,但训练所需参数更多。

图14:单个视觉Transformer(ViT)模型可以提供特征集合,因为每个模块的类别令牌都可以由分类器独立处理。这使我们能够识别出对迁移学习最有用、最具判别力的令牌。

图15:ImageNet验证集上,由每个视觉Transformer(ViT)模块生成的类别令牌的top-1准确率(%)。最后几层的类别令牌表现最佳,这表明它们是最具判别力的令牌。

表5:使用在ImageNet上预训练的DeiT-S [3],在三个数据集上进行现成特征转移的消融研究。通过连接不同块的类令牌,或连接类令牌与平均补丁令牌的组合,来训练一个线性分类器。我们注意到,第9 - 12块的类令牌最具判别力(见图15),在top-1准确率方面具有最高的可迁移性。 - 视觉分类任务中的应用:在多个视觉分类数据集(如Aircraft、CUB、DTD、GTSRB、Fungi、Places365和iNaturalist)上,使用从ImageNet预训练的ViT模型提取的特征训练线性分类器,并在测试集上评估性能。结果显示,ViT特征相较于CNN基线有明显提升,其中DeiT-T模型参数约为ResNet50的五分之一,但在所有数据集中表现更优,且采用集成策略的模型在所有数据集上取得了最佳结果。

- 少样本学习任务中的应用:在包含多个领域数据集的大规模少样本学习基准meta-dataset上进行实验。使用在ImageNet上预训练的网络提取特征,在每个下游数据集的少样本学习设置下,利用支持集图像的特征学习线性分类器进行评估。结果表明,ViT特征在这些不同领域的转移性能优于CNN基线,且采用集成策略可进一步提升ViT的转移性能,在包含手绘草图的QuickDraw数据集中,ViT的表现提升也与其在形状偏置方面优于CNN的结论相符。

图16:现成的视觉Transformer(ViT)特征的迁移效果优于卷积神经网络(CNNs)。我们通过通用分类以及针对域外任务的少样本分类,探究学习到的表征的可迁移性。在分类任务(左图)中,在ImageNet上预训练的ViT在不同任务中的迁移效果优于对应的CNN。在少样本学习任务(右图)中,在ImageNet上预训练的ViT平均表现更优。

讨论和结论-Discussion and Conclusion

这部分主要对研究进行总结和讨论,阐述了ViT在多方面的优势、研究存在的局限,并提出了未来研究方向,具体如下:

- 研究结论:通过对多种ViT模型在十五个视觉数据集上的测试,验证了ViT在处理遮挡、分布转移、补丁排列、自动分割以及抵抗对抗攻击和常见损坏方面,相较于CNN具有明显优势。同时,单个ViT模型的现成特征经组合形成的特征集合,在多个下游任务中展现出强大的转移性。

- 未来研究方向

- 多线索融合:探索如何有效结合ViT中不同令牌建模的多种线索,使其相互补充,进一步提升模型性能。

- 改进自动分割:研究将本文方法与DINO相结合的可行性,如探究基于风格化ImageNet(SIN)的自监督能否提升DINO的分割能力,以及修改DINO训练方案,融合基于纹理(IN)的局部视图和基于形状(SIN)的全局视图,是否能增强其自动分割能力并使其更具通用性。

- 研究局限:当前实验基于ImageNet(ILSVRC’12)预训练的ViT,该数据集存在潜在偏差,数据多来自西方,包含性别、种族刻板印象且部分群体代表性不足,同时还存在隐私风险,未来将使用改进版本的ImageNet进行研究。