【人工智能agent】--dify搭建智能体和工作流

【人工智能agent】--docker本地部署dify教程-CSDN博客

上期讲到如何部署dify,然后进入页面:

docker服务:

目录

1.基础设置

2.创建聊天助手

3.创建知识库应用

4.创建智能体

5.创建工作流

5.1.文档总结规划

5.2.爬取网页新闻

1.基础设置

搭建智能体前提是配置好agent的大脑,也就是大模型,

点击设置-->模型供应商

安装对应的模型供应商,

设置好对应的api即可使用,然后本地部署ollama教程:https://zhuanlan.zhihu.com/p/715099487

(容易出错)

由于ollama是部署在本地的,而dify是部署在docker上面的虚拟环境,所以要实现一个网络闭环

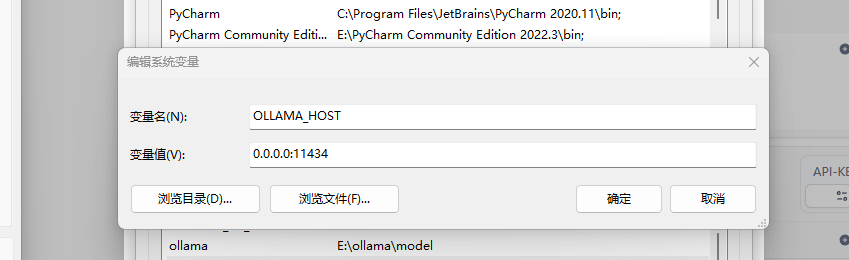

1. 添加系统环境变量:

名:OLLAMA_HOST

值:0.0.0.0:11434

重启一下。

2.启动ollama:ollama serve

3. 获取主机ip:ipconfig

至于deepseek和千问直接去官网获取api-key即可:

DeepSeek 百炼控制台

2.创建聊天助手

1.创建空白应用,选择聊天助手

2.添加提示词和输入内容

“提示词”可以对AI做出的回答进行限定和约束,它不会被用户看到。提示词可以通过生成器自动生成,

“变量”是配合提示词用的,在对话前填写将自动替换提示词里的内容。

“知识库”就是想要大模型回答材料背景

3.创建知识库应用

为方便测试,先在本地创建一个“半期考试成绩”的EXCEL文件,内容如下:

姓名 语文 数学 英语 总分

张三 95 97 99 291

李四 73 85 95 253

王二 88 83 96 267

周五 92 88 93 273

马六 85 91 97 3273有点像RAG的形式,想给出需要检索的内容,然后严格按照内容知识回答

在知识库页面选择创建知识库。将需要导入的数据文件拖动到指定区域,执行“下一步”。

分别对“分段设置”、“索引方式”、“Embedding 模型”、“检索设置”等进行设置,这里我把Top K设置为8,

采用Q&A分段模式:生成知识问答对

完成知识库创建后,创建一个聊天应用,并在“上下文”里添加该知识库,然后就可以在聊天应用中调用知识库了。

4.创建智能体

在聊天应用基础上增加工具调用就可以构建智能体应用了,在这里我们构建一个名为“每日要闻”的新闻搜索应用。

- 首先设置提示词“你是程序员,善于运行代码。

- 然后添加“工具”,这里添加一个“代码运行”和“获取当前时间”的工具,

- 并根据需求对工具进行配置,注意部分工具需要先获得授权才能应用。

5.创建工作流

工作流应用创建稍微复杂一些,它以工作流形式定义编排生成应用,可生成较复杂的自定义应用,这里我们以系统在“探索”页面的提供的模板为例。

5.1.文档总结规划

下面是一个简单的网页爬虫工作流,支持输入一个关键词,并通过网页爬虫爬取相应的信息,然后使用大模型进行总结。

1.创建工作流

添加输入参数 ,开始节点 -> 选择"单文件"作为输入

2. 添加“文档提取器”,大模型没有办法直接处理文档,因此添加一个“文档提取器”的节点。

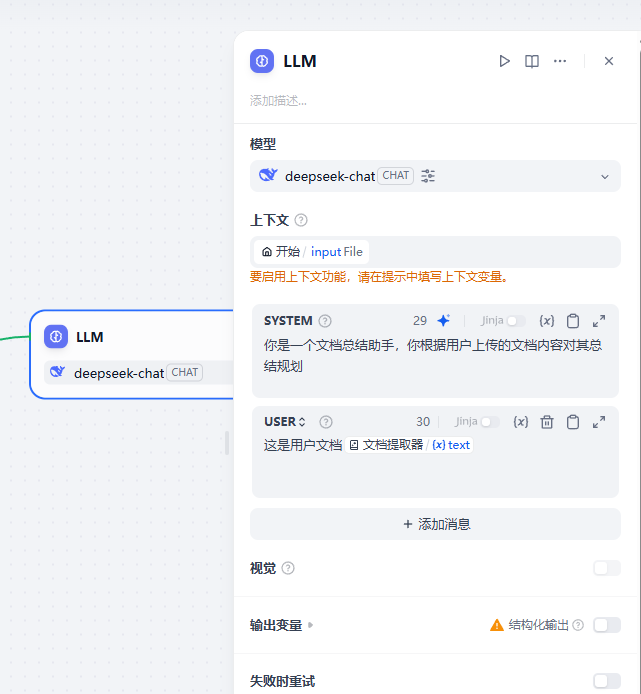

3. LLM大模型节点,输入一些提示词、用户信息、输出变量:

你是一个文档总结助手,你根据用户上传的文档内容对其总结规划

这是用户文档

4.添加结束输出节点,一大模型总结的内容作为输出

5.完整工作流:

6.测试:

5.2.爬取网页新闻

1.在添加节点的工具栏中找到网页爬虫

这个节点只需要输入一个网址,它的生成变量有text、files、json,我们用到的是text。

2.再添加一个LLM节点来分析这个text

4.输出结果

从“苦甲天下”到陇原振兴——甘肃脱贫攻坚口述-新华网