数字人源码部署-支持oem

在科技日新月异的今天,AI 数字人正在彻底改变多个行业的面貌。从娱乐直播中的虚拟明星到企业智能客服的形象,其应用范围持续扩大。本文将深入探讨一个名为“123 数字人”的 AI 数字人系统源代码,特别关注它的核心技术——即时驱动,为开发者和技术爱好者提供一个详尽的技术手册,帮助大家了解其中的精妙之处,或者基于此开展个性化开发。

二、系统架构一览

(一)数据层

作为整个数字人系统的基础,数据层存储了海量的关键信息。这包括高保真的三维数字人模型数据,精细到每个骨骼结构和肌肉纹理,准确描绘数字人的外观;丰富的动作捕捉数据,来源于专业设备的采集或深度学习生成,为数字人的动作提供了多样的样本;语音样本库,包含了多种音色、语调和方言素材,赋予了数字人逼真的语音能力;还有用户交互历史的记录,为个性化服务奠定了坚实的数据基础。

(二)模型层

数字人分身技术探秘:从外观到互动,一步步打造虚拟世界的新居民

在这个数字时代,我们见证了人工智能技术的飞速发展,其中最引人瞩目的莫过于数字人分身技术。这项技术利用了最新的深度学习算法,如生成对抗网络(GANs)和变分自编码器(VAE),通过分析大量的人脸和人体图像数据,能够创造出形态各异、栩栩如生的数字人物形象。这些数字人不仅外观逼真,而且能够满足不同场景下的审美需求,无论是时尚杂志封面还是电影特效制作,都能游刃有余。

除了外观上的精准塑造,数字人的动态表现同样重要。这得益于动作预测模型的应用,它基于循环神经网络(RNN)及其改进版本,如长短期记忆网络(LSTM)和门控循环单元(GRU)。这些先进的模型能够深入解析历史动作序列,预测并生成下一时刻的动作,确保数字人在各种情境中的动作连贯自然,逻辑清晰。

语音交互是数字人分身技术的另一大亮点。通过集成自动语音识别(ASR)和语音合成(TTS)技术,数字人能够理解人类的语音指令并以自然流畅的语言进行回应。ASR技术依托于卷积神经网络和Transformer模型,而TTS则利用WaveNet、Tacotron等先进算法,将文本信息转化为生动的语音输出,实现了真正意义上的人机“对话”。

至于数字人分身源码的构建,虽然涉及复杂的编程知识和算法实现,但基本原理是相通的。开发者需要掌握Python、TensorFlow或PyTorch等工具,根据上述技术框架设计和训练模型。此外,还需要处理大量数据集,进行模型调优和测试,以确保最终成果的稳定性和实用性。

数字人分身技术正逐步改变我们的娱乐方式、工作模式乃至社会交往。随着技术的不断进步,未来的数字人将更加智能、更加真实,成为我们生活中不可或缺的一部分。

此为系统的"心脏"部分,主要负责整合数据和模型结果,以实时回应外界的各种刺激。它能够接收摄像头拍摄的用户动作、表情以及麦克风录入的语音指令;通过快速算法的处理,即刻驱动数字角色做出相应的动作和表情变化,并同时输出准确的语音回应。这使得数字角色能像真人一般进行实时互动。

(四)渲染层

本层使用OpenGL、DirectX等图形渲染技术,将数字角色的实时动态效果生动地展现出来。它处理光影变换,模拟出真实的光照环境,使数字角色的皮肤和服装质地看起来极为逼真;同时优化了渲染管线,加快了图像处理流程,即使在复杂场景下也能确保数字角色流畅且无卡顿。

数字人分身(原视频)

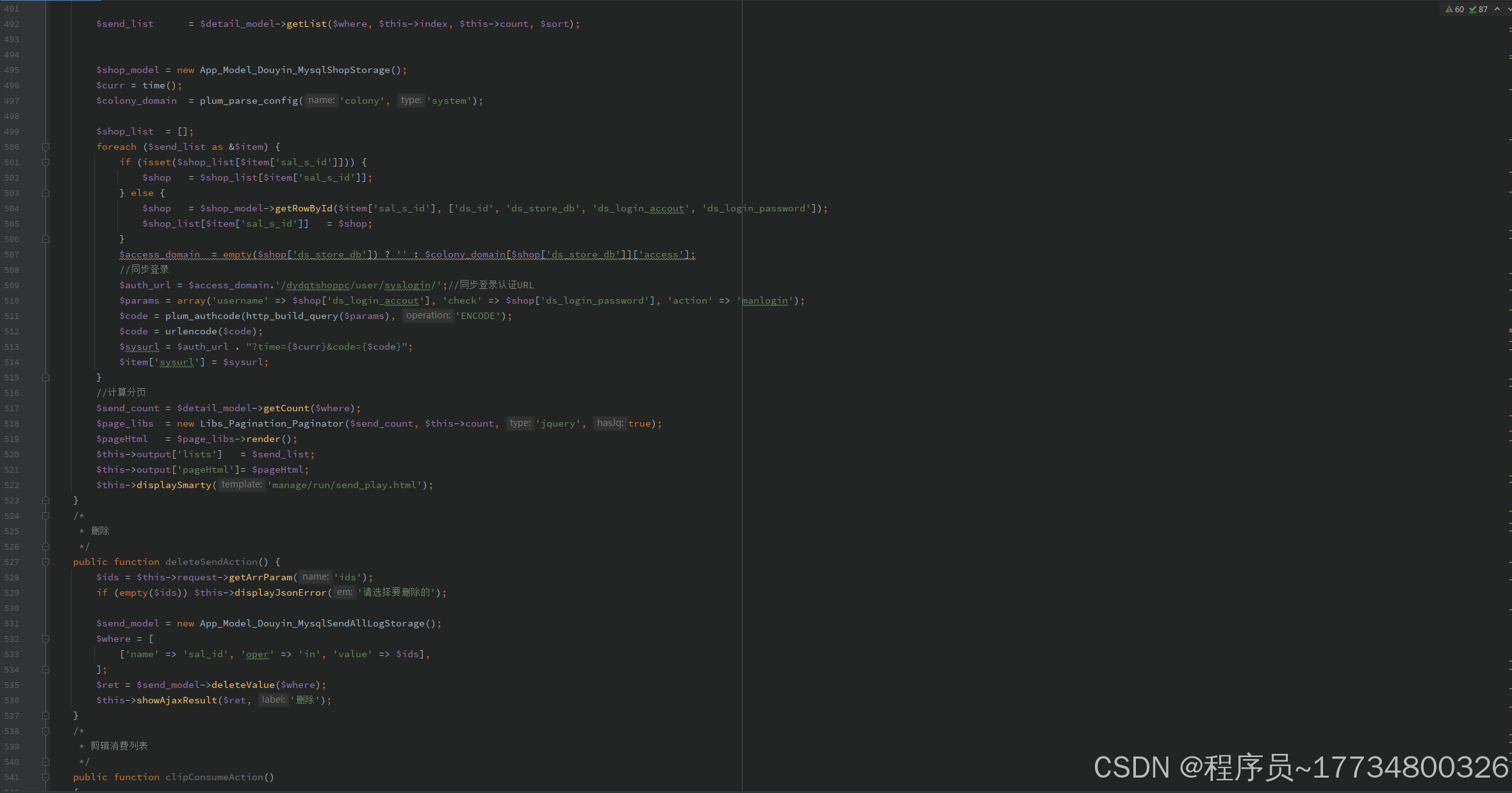

三、关键源码解析

(一)实时动作捕捉与驱动

以下是一些关于数字人物分身的关键源码:

python

引入必要的库

import cv2

import mediapipe as mp

加载MediaPipe人体姿态检测模型

mp_pose = mp.solutions.pose

初始化视频捕获对象

cap = cv2

以上内容仅为示意,具体实现需根据实际需求编写。

文章内容:创建一个数字人分身的代码示例

我们需要导入必要的库。在这个例子中,我们将使用MediaPipe Pose来检测人体姿态。

import cv2

import mediapipe as mp

# 初始化 MediaPipe Pose 对象

pose = mp.solutions.pose.Pose()

# 打开摄像头isOpened():

success, frame = cap.read()

if not success:

continue

# 将图像转换为RGB格式,因为MediaPipe使用的是RGB格式

rgb_frame = cv2.cvtColor(frame, cv2.COLOR_BGR2RGB)

results = pose.process(rgb_frame)

if results.pose_landmarks:

# 获取人体关键点坐标pose_landmarks.landmark):

h, w, c = frame.shape

cx, cy = int(landmark.x * w), int(landmark.y * h)

landmarks.circle(frame, (cx, cy), 5, (0, 255, 0), -1)

print("Landmarks:", landmarks)

cv2.imshow('MediaPipe Pose', frame)

if cv2.waitKey(1) & 0xFF == ord('q'):

break

cap.release()

cv2.destroyAllWindows()

这段代码演示了如何使用MediaPipe Pose来检测视频中的人体姿态,并将检测到的关键点以圆点的形式标记在图像上。同时,它还打印出了每个关键点的ID和坐标。

我们从MediaPipe Pose模块获取人体关键点的坐标,并将这些坐标存储在名为landmarks的数组中。然后,我们使用这些关键点来驱动数字人的虚拟形象,使其与真实人物的动作保持同步。接下来,我们将图像从RGB格式转换为BGR格式以便于显示。最后,我们展示转换后的图像,并检查是否有按键被按下以结束程序。如果按下了“ESC”键(ASCII码为27),则退出循环,释放摄像头资源,并销毁所有OpenCV窗口。以下是具体的代码实现:

import numpy as np

import cv2

# 假设results.pose_landmarks.landmark是包含人体关键节点的对象列表

landmarks = np.array([[lmk.x, lmk.y, lmk.z] for lmk in results.pose_landmarks.landmark])

# 此处对接数字人动作驱动模块,依据关键点调整数字人姿态

drive_digital_human(landmarks)

# 将图像转换回 BGR 格式用于显示

image = cv2.cvtColor(image, cv2.COLOR_RGB2BGR)

cv2.imshow('MediaPipe Pose', image)

# 等待用户按键,如果按下“ESC”键则退出循环

if cv2.waitKey(5) & 0xFF == 27:

break

# 释放摄像头资源并关闭所有OpenCV窗口

cap.release()

cv2.destroyAllWindows()

语音实时交互

以下是实现语音识别和合成的 Python 代码:

import speech_recognition as sr

import pyttsx3

# 初始化语音识别与合成引擎

recognizer = sr.Recognizer()

engine = pyttsx3.init()

# 定义语音识别函数

def recognize_speech():

with sr.Microphone() as source:

print("请说话...")

audio = recognizer.listen(source)

try:

recognized_text = recognizer.recognize_google(audio, language='zh-CN')

print(f"你说:{recognized_text}")

engine.say(recognized_text)

engine.runAndWait()

except sr.UnknownValueError:

print("无法识别语音,请重试。")

except sr.RequestError:

print("请求错误,请检查网络连接。")

# 调用语音识别函数

recognize_speech()

上述代码展示了如何使用 speech_recognition 和 pyttsx3 库进行简单的语音识别和文本到语音(TTS)合成。用户只需对着麦克风说话,该程序即可识别语音内容并通过数字人进行复述。这种语音交互功能可以进一步增强数字人的智能表现,使其更具人性化和互动性。

在数字世界的广阔舞台上,我们经常遇到需要将语音转化为文本的情况。想象你正在和一位朋友交谈,但这次交谈不是面对面的,而是通过一个由代码构成的智能体来完成的。这就是数字人分身的用武之地。以下是如何通过简单的Python脚本来实现这一功能的示范。

我们需要引入必要的库来帮助我们识别语音。这个过程类似于教计算机“听”和“理解”人类的语言。一旦我们有了音频输入,就可以使用recognize_google函数从Google的语音识别服务中获取转录文本。如果一切顺利,程序会打印出:“你说的是: ”加上识别到的文本。

就像在任何技术领域一样,总有可能遇到障碍。如果系统无法理解所说的内容,它会捕捉到一个UnknownValueError异常,并告诉我们“无法识别语音”。另一个可能遇到的问题是请求错误,这时它会打印出错误的详细信息,帮助我们了解问题所在。

接下来,让我们看看如何让计算机“说话”。通过一个简单的函数speak_text,我们可以让计算机发出声音。这个函数接受一个文本参数,然后使用一个叫做engine的对象将文本转换成语音,最后播放出来。

整个过程是通过一个循环来控制的,不断监听用户的输入,直到程序被手动停止。每当用户说出一段话,这段语音就会被转换成文本,并且可以通过计算机“回复”,创建一个互动的对话环境。

这种技术的应用范围非常广泛,从智能家居助手到客户服务机器人,都可以看到它的身影。通过理解和实现这样的代码,我们不仅能够创建出有用的工具,还能深入理解人机交互的本质。

# 数字人分身源码:让对话更加自然流畅

在当今科技飞速发展的时代,数字人的出现为我们带来了全新的交互体验。通过结合语音识别和语音合成技术,我们可以实现对用户语音指令的实时处理,并以数字人的形式进行精准回应,为用户打造自然流畅的对话体验。

下面,我们将介绍一个简单的数字人分身源码示例,以帮助您更好地理解和实现这一功能。

## 一、代码实现

我们需要使用Python语言编写一个程序,该程序将整合`speech_recognition`和`pyttsx3`库,以实现语音识别和语音合成功能。具体代码如下:

```python

import speech_recognition as sr

import pyttsx3

def process_user_text(text):

# 在这里添加您的文本处理逻辑

return "Hello, how can I help you?"

def speak_text(text):

engine = pyttsx3.init()

engine.say(text)

engine.runAndWait()

# 初始化语音识别引擎

recognizer = sr.Recognizer()

while True:

with sr.Microphone() as source:

print("请说点什么...")

audio = recognizer.listen(source)

try:

user_text = recognizer.recognize_google(audio, language='zh-CN')

print("您说的是:" + user_text)

response_text = process_user_text(user_text)

speak_text(response_text)

except sr.UnknownValueError:

print("无法识别音频,请再说一次。")

except sr.RequestError as e:

print("请求错误:{0}".format(e))

上述代码中,我们首先导入了所需的库,并定义了两个函数:process_user_text用于处理用户的文本输入,speak_text用于将文本转换为语音并输出。接着,我们初始化了一个语音识别引擎,并通过一个循环实时监听用户的语音输入。当检测到语音输入后,程序会将其转换为文本并调用process_user_text函数进行处理,然后通过speak_text函数将处理后的文本转换为语音并输出。

二、渲染优化核心片段

在数字人的渲染过程中,我们还需要使用OpenGL等图形库来进行渲染优化。以下是一个简化的示例代码:

// 使用 OpenGL 进行渲染示例(简化示意)

#include <GL/glut.h>

// 数字人模型结构体

struct DigitalHumanModel {

// 模型顶点、纹理等数据成员

//...在这里添加您的渲染逻辑

glFlush();

}

int main(int argc, char** argv) {

glutInit(&argc, argv);

glutCreateWindow("数字人");

glutDisplayFunc(display);

glutMainLoop();

return 0;

}

上述代码中,我们定义了一个DigitalHumanModel结构体来存储数字人的模型数据。在display函数中,我们使用OpenGL函数来进行渲染操作。最后,在main函数中,我们初始化了OpenGL环境并进入主事件循环。

通过以上示例代码的介绍,我们可以看到数字人分身源码的具体实现过程。希望这些代码能够帮助您更好地理解和实现数字人技术,为用户带来更加自然流畅的对话体验。

数字人分身源码解析

在现代技术飞速发展的今天,数字人已成为了人们生活中的一部分。那么,如何创建一个逼真的数字人分身呢?下面,我们将通过一段简化的代码来探索这个过程。

我们需要定义一个数字人的模型。这可以通过以下代码实现:更新数字人的姿态 // 绘制数字人模型

};

接着,我们进入主函数`main`,这是程序的入口点。在这里,我们需要初始化图形库并设置一些基本参数。

```c++

int main() {

// 初始化图形库

initGraphicsLibrary();

// 创建数字人实例

DigitalHuman digitalHuman;

// 主循环

while (true) {

// 清除屏幕和深度缓存

clearScreenAndDepthBuffer();

// 更新数字人姿态以匹配实时驱动数据

digitalHuman.updatePose();

// 绘制数字人模型到屏幕上

digitalHuman.draw();

// 交换缓冲区,显示新的画面

swapBuffers();

}

return 0;

}

在上面的代码中,我们先是初始化了图形库,然后创建了一个DigitalHuman类的实例。随后进入一个无限循环,这个循环代表了程序的主渲染循环。在这个循环中,我们首先清除屏幕和深度缓存,然后根据实时数据更新数字人的姿态,并绘制出来,最后交换缓冲区以显示新的画面。

这段代码虽然简化了很多细节,但它展示了创建一个数字人分身的基本框架和流程。通过不断地优化和扩展,我们可以使这个数字人看起来更加真实,甚至能够与人类进行交互。

文章标题:数字人分身源码的奥秘

一、构建数字人的基础架构

我们需要搭建数字人的渲染框架。使用OpenGL库,我们可以创建出逼真的数字人形象。以下是一个简单的C++代码示例,它展示了如何初始化OpenGL环境,并创建一个窗口来显示我们的数字人。

glutInitDisplayMode(GLUT_DOUBLE | GLUT_RGB | GLUT_DEPTH); // 设置显示模式为双缓冲、RGB颜色模式和深度缓存

glutInitWindowSize(800, 600); // 设置窗口大小为800x600像素

glutCreateWindow("我的数字人分身"); // 创建窗口并命名为"我的数字人分身"

glutDisplayFunc(display); // 指定display函数作为当前窗口的显示回调函数

glutMainLoop(); // 进入GLUT事件处理循环

return 0;

二、数字人的动作与表情

要让数字人栩栩如生,我们需要让他能够动态地做出各种动作和表情。这需要我们编写一个名为update_digital_human_pose的函数,该函数负责实时获取驱动层数据,并根据这些数据调整数字人的姿态和视角。这样,无论用户如何操作,数字人都能做出相应的反应,给用户带来沉浸式的视觉体验。

三、系统集成与测试

在将数字人集成到其他系统或应用中时,需要注意以下几点:

-

确保数字人的渲染效果在不同硬件和软件环境下都能保持一致;

-

对数字人的性能进行优化,确保其在不同场景下的流畅运行;

-

对数字人的功能进行全面测试,确保其在各种情况下都能正常工作。

通过以上步骤,我们就可以成功地将数字人集成到其他系统或应用中,为用户带来全新的交互体验。

跨语言合作:考虑到源码需要用到Python、C++等多种编程语言,我们利用Python的ctypes库和C++的extern "C"语法巧妙地进行接口封装。这样做可以确保不同语言编写的模块之间能精准传递数据,函数调用也能高效运行,使得各层级间的协作流畅无阻。为了优化数据流转,我们构建了一个高效的数据传输“通道”。在动作捕捉、语音识别以及模型驱动和渲染等环节之间,我们采用了缓存机制和异步传输技术,有效降低了数据传输的延迟,提升了系统的整体响应速度。

功能测试部分包括了动作同步测试和语音交互测试。在动作同步测试中,我们安排了专业人员进行各种复杂动作和表情的示范,然后将摄像头捕捉到的画面与数字人的实时响应进行比对,检查动作的匹配度和表情的还原精度,确保数字人的模仿能够达到精细入微的程度。对于语音交互测试,我们在模拟了嘈杂和安静等多种环境后,录入了不同语速和口音下的语音指令,以此来验证语音识别的准确性和合成语音的自然度。通过这些测试,我们可以确保数字人在对话时能够流畅自然地交流。

在数字人分身源码方面,我们的开发团队采用了先进的编程技术和架构设计,以确保数字人能够在不同的应用场景下都能表现出色。通过精心设计的算法和代码结构,我们的数字人分身不仅能够实现高度逼真的外观和动作,还能在各种交互场景中展现出智能化的响应能力。

文章内容:数字人物渲染效果大揭秘:从各个角度和光线下观察数字人物的图像,评估其外观细节和光影表现,确保在高速刷新率下画面依然流畅稳定,让数字人物看起来完美无瑕。五、探索与未来发展

(一)功能延伸

多感官交互体验增强:将手势识别和眼动追踪技术深度整合,使数字人物能够全面捕捉用户的细微动作;结合情感分析工具,数字人物可以根据用户的情感状态灵活调整交流方式,增加互动的自然感。情境模拟扩展:为教育界定制专业数字人物导师,集成知识讲授和实验室操作指导;在医疗环境中,数字人物可充当导诊助手,精确管理预约挂号和咨询流程,开辟新的应用领域。

(二)未来展望

AI数字人物平台“ABC 数字伙伴”,利用其实时控制特性,可在在线购物平台上扮演推销员角色,通过实时互动和生动的产品展示来显著提高销售效率;在客户服务方面,它能迅速响应客户询问,提供精确解答,减少人力开支;在文化旅游行业,它化身为虚拟导游,提供身临其境的景点讲解服务,重新定义旅游体验。