万亿参数大模型网络瓶颈突破:突破90%网络利用率的技术实践

AI数据中心网络热潮下,如何突破传统以太网利用率瓶颈?

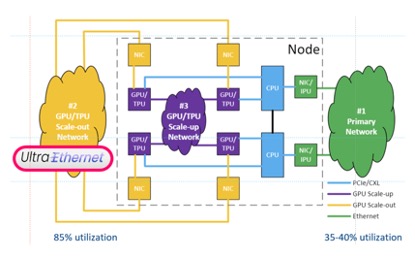

近年来,随着AI大模型训练(如GPT-4、Gemini)的爆发式增长,数据中心网络的流量压力急剧上升。单次训练任务可能涉及数千张GPU卡协同工作,生成集合通信流量(All-Reduce、All-to-All等),网络面临高并发、低延迟、无损传输的严苛需求。然而,传统以太网的网络利用率长期徘徊在35%~40%,成为制约AI算力释放的关键瓶颈。如何将利用率提升至85%甚至90%以上?这需要从架构设计、传输协议到调度算法的全面革新。

AI大模型训练催生网络利用率危机

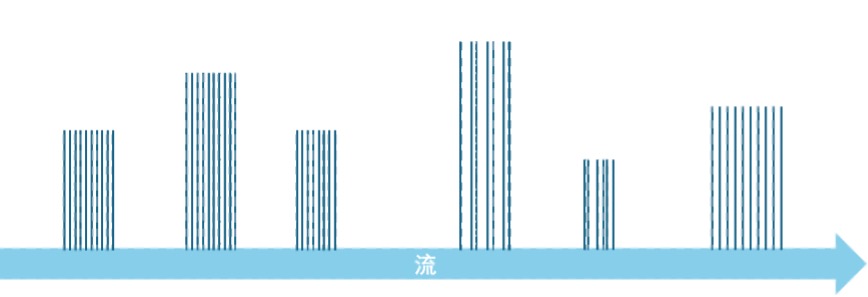

当前,AI训练任务的数据规模呈指数级增长。以混合专家模型(MoE)为例,其参数分布在不同GPU节点上,训练过程中频繁的梯度同步与参数更新会触发In-Cast拥塞——多源同时向单一目的节点发送数据,导致目的链路带宽瞬时耗尽。传统以太网依赖ECMP(等价多路径)进行负载均衡,但面对AI流量的高熵值特性(流持续时间长、包大小固定),ECMP的粗粒度Hash调度极易引发“流量极化”(部分链路过载而其他链路闲置)。

超级以太网:从架构到协议的效率革命

超以太网联盟(UEC)提出了一套系统性解决方案,目标是将网络利用率提升至85%以上,其核心技术涵盖以下维度:

1. 无损传输:从粗暴丢弃到精准控制

传统以太网在拥塞时直接丢弃报文,而UEC引入端到端无损传输技术,结合RoCEv2的PFC(优先级流量控制)和ECN(显式拥塞通知),实现微秒级拥塞反馈。例如,当交换机检测到队列深度超过阈值时,通过ECN标记数据包头部,通知接收端触发速率调节,避免全局性丢包。针对In-Cast拥塞,UEC进一步提出INC(In-Network Computing)技术,允许交换机在传输过程中对All-Reduce流量进行梯度聚合,减少冗余数据传输量。

2. 拓扑革新:CLOS架构与动态无阻塞

传统三层网络架构(接入-汇聚-核心)因收敛比限制,难以避免纵向带宽瓶颈。UEC采用CLOS无阻塞拓扑,通过横向扩展实现“任意端口间均可直达”,总接入带宽与核心带宽保持1:1。然而,CLOS架构仍需应对局部链路拥塞问题。为此,UEC提出包喷洒(Packet Spraying)技术,将单条流的报文分散到多条等价路径,结合传输层协议支持乱序重组,最大化利用全网带宽。实验表明,包喷洒可将长流(如AI训练流)的链路利用率提升30%以上。

3. 拥塞机制:UEC传输层改进方案

当In-Cast拥塞产生后,目前主要通过端到端的流控机制来缓解这一问题。例如,基于ECN的DCQCN/DCTCP技术通过调节源端的发送流量速率,适应网络的可用带宽。由于ECN携带的信息只有1个bit,这种调节方式不够精确。例如,DCQCN在收到ECN后,首先会大幅度降低速率,然后逐步提高速率,直到与可用带宽匹配。这个过程较为缓慢,期间网络带宽的利用率明显不足。为了解决这一问题,UEC传输层(UET,Ultra Ethernet Transport Layer)提出了以下改进措施:

-

加速调整过程:UET通过测量端到端延迟来调节发送速率,并根据接收方的能力通知发送方调整速率,快速达到线速。

- 基于遥测:来自网络的拥塞信息可以通告拥塞的位置和原因,缩短拥塞信令路径并向终端节点提供更多信息,从而实现更快的拥塞响应。

解锁90%利用率的关键实践

作为UEC核心成员,星融元通过自研技术进一步突破利用率极限,其创新点包括:

1、Flowlet:微突发流量的精细化调度

AI训练流量具有显著的计算-通信交替特性,通信阶段产生大量微秒级突发流量(Flowlet)。星融元利用Flowlet间的空闲间隔(>100μs),将其动态调度至不同路径,既避免报文乱序,又实现负载均衡。例如,在ResNet-152训练任务中,Flowlet技术将网络吞吐量提升22%,时延降低15%。

2、基于遥测的路由

2、基于遥测的路由

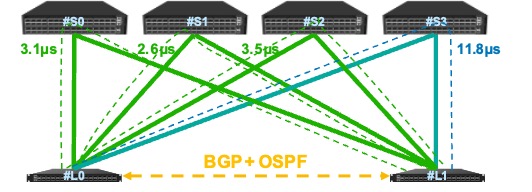

为了将包、flowlet或整个流调度到不同的路径上,需要路由协议的控制。传统的路由协议,基于静态的网络信息来计算最优路径,如OSPF基于网络带宽计算最短路径,BGP根据AS-PATH长度计算ECMP等。这种控制与网络实际负载脱节,需要加以改进。

基于遥测的路由(Int-based Routing)技术结合OSPF、BGP和在网遥测(INT)技术,为网络中任意一对节点之间计算多条路径,每个路径的开销是动态测量的延迟,从而能够根据实时的网络负载进行路由,从而充分利用每个路径的带宽。

3、WCMP

ECMP技术将包、flowlet或整个流均匀的分布到多个路径上,忽略了不同路径上的实际负载。为了进一步提升网络利用率。星融元采用加权代价多路径(Weighted Cost Multiple Path)算法,基于遥测获取的时延等信息,在时延更低的路径上调度更多的流量,在时延更高的路径上调度更少的流量,从而实现所有路径的公平利用。在理想情况下,流量经过不同路径的总时延是相等的,可充分利用所有可用带宽。

【参考文献】

- [1] Ultra Ethernet Consortium, “Ultra Ethernet Introduction” 15th October 2024.

- [2] Asterfusion, “Unveiling AI Data Center Network Traffic” https://cloudswit.ch/blogs/ai-data-center-network-traffic/.

- [3] Asterfusion, “What is Leaf-Spine Architecture and How to Build it?” https://cloudswit.ch/blogs/what-is-leaf-spine-architecture-and-how-to-build-it/.